ImageBind:跨六种模式的整体人工智能学习_环球快报

今天,我们推出了一种方法,使机器更接近人类同时、整体和直接从许多不同形式的信息中学习的能力——不需要明确的监督(组织和标记原始数据的过程)。我们已经构建并正在开源ImageBind,这是第一个能够绑定来自六种模式信息的人工智能模型。该模型学习单一嵌入或共享表示空间,不仅适用于文本、图像/视频和音频,还适用于记录深度 (3D)、热(红外辐射)和惯性测量单元 (IMU) 的传感器,这些传感器计算运动和位置。ImageBind使机器具备全面的理解力,将照片中的对象与它们的声音、3D 形状、冷暖感知以及移动方式联系起来。

如论文所述,ImageBind 可以胜过先前针对特定模态单独训练的专家模型。最重要的是,它有助于推进人工智能,使机器能够更好分析多种不同形式的信息。例如,基于ImageBind,Meta Make-A-Scene可以从音频创建图像,例如根据雨林或熙熙攘攘市场的声音创建图像。其他未来的可能性包括以更准确的方式识别、连接和调节内容,以及促进创意设计,例如更无缝生成更丰富的媒体和创建更广泛的多模式搜索功能。

(相关资料图)

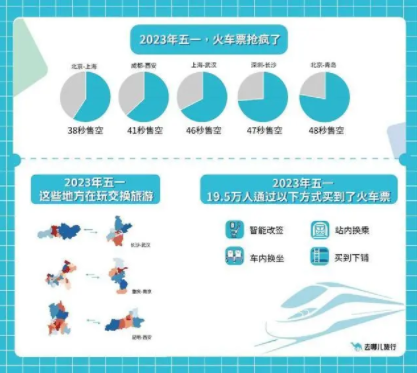

(相关资料图)

ImageBind是Meta致力于创建多模态AI系统的一部分,该系统可以从周围所有可能类型的数据中学习。随着模态数量的增加,ImageBind为研究人员打开了尝试开发新整体系统的闸门,例如结合3D和IMU传感器来设计或体验身临其境的虚拟世界。ImageBind还可以提供一种探索记忆的丰富方式——使用文本、音频和图像的组合来搜索图片、视频、音频文件或文本消息。

在典型的人工智能系统中,每个模态都有特定的嵌入(即可以表示数据及其在机器学习中关系的数字向量)。ImageBind可以跨多种模态创建联合嵌入空间,而无需使用每种不同模态组合对数据进行训练。这一点很重要,因为研究人员无法创建包含来自城市街道的音频数据、热数据、深度数据、海边悬崖文本描述等样本的数据集。

正如近来基于文本生成图像、视频和音频方面取得了令人兴奋的进展(例如Make-A-Scene和Meta Make-A-Video),ImageBind的多模式功能可以让研究人员使用其他模式作为输入查询和检索以其他格式输出。ImageBind也是朝着构建能够像人类一样全面分析不同类型数据的机器迈出的重要一步。

ImageBind是一个多模态模型,加入了Meta一系列开源AI工具。这包括像DINOv2这样的计算机视觉模型,一种不需要微调训练高性能计算机视觉模型的新方法,以及Segment Anything (SAM),一种通用分割模型,可以根据用户提示分割图像中的任何对象。而ImageBind 补充了这些模型,因为它专注于多模态表示学习。它尝试为多种模态学习单一对齐的特征空间,包括但不限于图像和视频。未来,ImageBind可以基于DINOv2强大的视觉功能进一步提高其能力。

通过将内容与图像绑定来学习单个嵌入空间

人类有能力仅从几个例子中学习新概念。我们通常可以通过阅读对某种动物的描述,然后在现实生活中认出。我们还可以查看一张不熟悉的汽车模型照片,并预测其发动机的声音。这在一定程度上是因为一张图片实际上可以将整个感官体验“绑定”在一起。然而,在人工智能领域,随着模态数量的增加,多感官数据的缺乏会限制依赖配对数据的标准多模态学习。理想情况下,一个单一的联合嵌入空间——其中分布着许多不同类型的数据——可以让模型学习视觉特征以及其他模式。

以往,学习所有模式的联合嵌入空间需要收集成对数据的所有可能组合,这是一项不可行的壮举。

ImageBind基于大规模视觉语言模型,并通过往语言模型与图像的自然配对(如视频音频和图像深度数据)来学习单个联合嵌入空间,将zero-shot功能扩展到新的模式,从而规避了这一挑战。对于另外四种模式(音频、深度、热量和IMU读数),我们使用自然配对的自监督数据。

由于互联网上大量的图像和同时出现的文本,训练图像文本模型已被广泛研究。例如使用 Web数据将文本链接到图像,或者使用从可穿戴相机捕获的视频数据将运动链接到视频IMU 传感器。

从大规模网络数据中学习的视觉表征可以用作学习不同模式特征的目标。这支持ImageBind 对齐与图像同时出现的任何模态,自然对齐这些模态。与图像有很强相关性的模态,例如热和深度,更容易对齐。非视觉的模式,如音频和IMU,相关性较弱。

ImageBind表明,图像配对数据足以将这六种模式绑定在一起。该模型可以更全面解释内容,支持不同的模式相互“交谈”并找到链接。这使其他模型无需任何资源密集型培训即可“理解”新模式。ImageBind强大缩放行为支持模型替代或增强许多AI模型,使它们能够使用其他模式。例如,虽然Make-A-Scene可以使用文本提示生成图像,但ImageBind可以将其升级为通过音频生成图像。

图像对齐、自监督学习表明,模型的性能实际上可以通过使用很少的训练示例来提高。模型具有新的紧急能力,或扩展行为——也就是说,在较小的模型中不存在但出现在较大的版本中的能力。这可能包括识别哪些音频适合特定图像或预测照片场景的深度。

我们的分析表明,ImageBind的缩放行为随着图像编码器的强度而提高。换句话说,ImageBind 对齐模态的能力随着视觉模型的强度和大小而增加。这表明更大的视觉模型有利于非视觉任务,例如音频分类,并且训练此类模型的好处超出了计算机视觉任务。

在我们的实验中,我们使用了ImageBind的音频和深度编码器,并将它们与zero-shot检索以及音频和深度分类任务中的先前工作进行了比较。

基于基准测试,ImageBind在音频和深度方面优于专业模型。我们发现ImageBind特征可用于少镜头音频和深度分类任务,并且可以胜过为这些模式量身定制的先前方法。例如,ImageBind明显优于Meta在Audioset上训练的自监督AudioMAE模型和在音频分类上微调的监督AudioMAE模型,在≤四次分类上的top-1准确度提高了大约40%。

ImageBind还在跨模态的紧急zero-shot识别任务上实现了新的最先进的性能,甚至优于经过训练以识别该模态概念的最新模型。

多模式学习的未来

通过使用多种模式进行输入查询和跨其他模式检索输出,ImageBind为创建者展示了新的可能性。想象一下,有人可以拍摄一段海洋日落的视频,并立即添加完美的音频剪辑来增强它,而斑纹西施犬的图像可以产生类似狗的论文或深度模型。

人们甚至可以根据音频分割和识别图像中的对象。这创造了独特的机会,可以通过将静态图像与音频提示相结合来从静态图像中创建动画。例如,创作者可以将图像与闹钟和公鸡打鸣结合起来,并使用打鸣的音频提示来分割公鸡或使用闹钟的声音来分割时钟并将两者制作成视频序列。

虽然我们在当前的研究中探索了六种模式,但我们相信,引入连接尽可能多的感官(如触觉、语音、嗅觉和大脑fMRI信号)的新模式将使以人为中心的人工智能模型更加丰富。

关于多模态学习,还有很多东西有待发现。AI研究界还没有有效量化只出现在更大模型中的缩放行为,并理解它们的应用。ImageBind正朝着以严格的方式评估展示图像生成和检索新颖应用迈出新的一步。

来源:AI.Facebook

人工智能标签:

- 父母可以继承女儿遗产吗?女子能继承父母遗产吗?

- 一年一交的意外险是什么(人身意外险怎么买)

- iPhone 15 Pro系列设计细节曝光:1.55mm极窄边框 弧边处理手感完美

- 杭州房产税是多少?杭州为什么叫停房产税?

- 哈弗h4隐藏功能有哪些(哈弗h4油门延迟怎么回事)

- 如何绘制曲线图?曲线图在电脑上面怎么做呢?

- 曲线图在电脑上面怎么做呢?在表格中绘制曲线图的操作方法是什么?

- 八种重要证件丢失补办攻略是什么?重要证件丢失可以报警调监控吗?

- 胡椒粉是用什么做的?胡椒粉吃了对身体有什么好处?

- 老三板在哪里看盘?老三板交易规则是什么?

- 桌面图标变大了怎么调小 桌面图标变成白色文件怎么恢复?

- 糖放太多酵母会不会失效?怎么鉴定酵母是否失效?

- 老三板股票怎么开户?老三板是什么?老三板股票交易软件有哪些?

- 甘肃省农村信用社联合社原纪委书记王蓉生接受审查调查 世界讯息

- 酵母粉开袋后能放多久?酵母化开后多久失去功效?

- 微软与英伟达支持的CoreWeave签署价值数十亿美元的AI算力交易

- 椒盐皮皮虾要不要剥壳吃 椒盐皮皮虾需要哪些材料?

- dtu的工作原理是什么?dtu的核心功能是什么?

- 金融风险包括哪些?金融风险预警系统是什么?

- 大小非是什么意思?大非小非可以大宗交易吗?

- 天天观天下!【乡村振兴在青海】技能培训,烹饪乡村振兴“好味道”

- 许昌市市长刘涛到禹州市调研指导麦收工作

- 大病保险一年多少钱(一年一交的大病保险是什么)

- 染发对冲是什么意思?星盘对冲是什么意思?

- 仙佑医药膏药的种类和选择? 郑州仙佑膏药的质量控制 天天时快讯

- 债基为什么会突然大幅下跌?债基的收益一般是多少?

- 外地银行卡可以作为工资卡吗?工资卡为什么要指定银行?

- 宫锁心玉是哪一年的电视剧?宫锁心玉剧情分集剧情介绍

- 已发生8起起火事故,捷豹路虎宣布紧急召回

- 理财产品双休日有收益吗?理财产品不保本的原因是什么?

- 父母可以继承女儿遗产吗?女子能继承父母遗

- 一年一交的意外险是什么(人身意外险怎么买

- iPhone 15 Pro系列设计细节曝光:1.55mm

- 杭州房产税是多少?杭州为什么叫停房产税?

- 哈弗h4隐藏功能有哪些(哈弗h4油门延迟怎么

- 如何绘制曲线图?曲线图在电脑上面怎么做呢

- 曲线图在电脑上面怎么做呢?在表格中绘制曲

- 八种重要证件丢失补办攻略是什么?重要证件

- 胡椒粉是用什么做的?胡椒粉吃了对身体有什

- 老三板在哪里看盘?老三板交易规则是什么?

- 桌面图标变大了怎么调小 桌面图标变成白色

- 糖放太多酵母会不会失效?怎么鉴定酵母是否

- 老三板股票怎么开户?老三板是什么?老三板

- 甘肃省农村信用社联合社原纪委书记王蓉生接

- 酵母粉开袋后能放多久?酵母化开后多久失去

- 微软与英伟达支持的CoreWeave签署价值数十

- 椒盐皮皮虾要不要剥壳吃 椒盐皮皮虾需要哪

- dtu的工作原理是什么?dtu的核心功能是什么?

- 金融风险包括哪些?金融风险预警系统是什么

- 大小非是什么意思?大非小非可以大宗交易吗

- 天天观天下!【乡村振兴在青海】技能培训,

- 许昌市市长刘涛到禹州市调研指导麦收工作

- 大病保险一年多少钱(一年一交的大病保险是

- 染发对冲是什么意思?星盘对冲是什么意思?

- 仙佑医药膏药的种类和选择? 郑州仙佑膏药

- 债基为什么会突然大幅下跌?债基的收益一般

- 外地银行卡可以作为工资卡吗?工资卡为什么

- 宫锁心玉是哪一年的电视剧?宫锁心玉剧情分

- 已发生8起起火事故,捷豹路虎宣布紧急召回

- 理财产品双休日有收益吗?理财产品不保本的